北京时间 4 月 23 日凌晨 2:40 左右,特斯拉发布了自动驾驶芯片。

这是特斯拉 Autopilot (以下称 AP)迄今为止取得的最大的技术突破,但另一方面,自动驾驶事关行车安全,我们每个人都应该保持足够的理性和克制,谨慎分析。特斯拉 AP 的技术架构、发展策略是如此的独特,它的种种策略到今天仍然充满了争议。因此,本文将分为对特斯拉、对行业、对用户三大部分展开。

其中涉及技术架构的部分可能稍显晦涩,但如果你是车主,仍然强烈建议你去尝试理解。对于车主来说,用户体验是最重要的。但技术架构是促成用户体验的

顶层

设计,了解技术架构能帮助你更好的理解这套系统的潜力和短板所在。

(如果你实在读不下去,请直接拉到最后看对用户篇)

对特斯拉

对于特斯拉来说,AP 最终达成了 Elon 想达成的目标。正如文章开头所说,这是自 2014 年 10 月 AP 诞生以来,特斯拉取得的最大的技术突破。

有充分的证据表明,英伟达 Drive PX2 芯片之于 AP 自始至终都是一个过渡角色。

2015 年 11 月 20 日深夜,Elon Musk 连发数条 Twitter 在线招人。那可能是他第一次提到,AP 团队的目标是实现自动驾驶,而加入 AP 团队的员工将由他本人亲自面试。除了 AP 团队直接向他汇报,所谓 This is a super high priority.

一个月后,顶级芯片大神 Jim Keller 及其团队集体加入特斯拉,Keller 出任 AP 硬件副总裁,AP 芯片研发团队成立。

10 个月后量产的 AP 2.0 车型,在设计之初就考虑了中央计算芯片可插拨,便于后期升级。

对特斯拉来说,以自主研发的自动驾驶芯片驱动

汽车完全是「蓄谋已久」。

特斯拉为什么要自行设计研发自动驾驶芯片?Jim Keller 给过一段解释:

在技术变革方面,我们正处于 AI 革命之中。

AI 的计算方式和经典的标量计算、矢量计算、图形计算都不一样,可以说差别巨大,应用非常广泛。每当有这样变革的时候,尤其是从硬件到顶层软件堆栈都在变革,就会有大量的人投身其中。

有一点是不变的,高端处理器的设计非常难做。将无数模块组合成差异化的、高价值的处理器非常难做。你看看现在的半导体行业,有些是来自大公司的标准产品,有些是自主设计的定制芯片。但不变的是,超级困难的挑战需要真正的专家来解决。

在 Elon Musk 看来,计算机视觉 + AI + 海量真实数据,是 AI 技术在汽车行业最艰难也最具想象力的应用场景。就像 Jim Keller 所说,AI 需要从软件到硬件底层设计全面的变革。

这就是特斯拉最初的动机,今天,特斯拉实现了这块芯片的量产。

下面先来介绍一下芯片本身。

这块芯片以 260 平方毫米的规格堆下了 60 亿个晶体管和 2.5 亿个逻辑门,峰值性能达到 36.8 TOPS,采用三星 14nm FinFET CMOS 工艺制造。

芯片搭载了频率为 4.266 GHz/s 的 LPDDR4 RAM,峰值带宽为 68GB/S,此外,特斯拉还在芯片上集成了一个 24 位通道的 ISP,支持高级色调映射和高级降噪。

除此之外,这块主板上还搭载了两块主频 2GHz 的神经

网络加速器(互为冗余),拥有 32MB 的SRAM 和 96×96 的阵列,数据处理速度 1TB/s。

图形芯片方面,该芯片支持 32 和 64 位浮点处理的图形芯片。同时植入了 12 个主频 2.2Ghz 的 64 位 CPU。

芯片具备一个独立安全芯片和 H.265 视频解码器。

最后,主芯片功耗仅为 75W,整个主板功耗 250W,意味着每行驶 4 小时,特斯拉芯片会消耗 1 度电。

你可能想知道 Mobileye 性能最强的量产芯片 EyeQ4 和英伟达性能最强的量产芯片 Drive PX2 芯片跟特斯拉自动驾驶芯片比,是什么水平?

首先,Mobileye EyeQ4 主要被用作感知芯片,定位不同,性能峰值仅为 2.5TOPS。所以,略。

Pete Bannon

关于 Drive PX2,官方有一张 PPT 做对比。特斯拉芯片的处理速度达到 2300帧/s,是 Drive PX2 的 110 帧/s 的 21 倍。在另一项对比中,Elon 提到特斯拉芯片的性能是英伟达下一代自动驾驶芯片 Drive Xavier 的 7 倍。

但在我看来,特斯拉这样毫不留情地欺负前芯片供应商英伟达并不合适。

虽然两者都定位自动驾驶中央计算芯片,但从芯片架构来看,特斯拉芯片已经向图像处理和 AI 计算全面倾斜,而英伟达两代芯片仍然是以 GPU 为核心的自动驾驶芯片。这使得英伟达在图像处理对比中会处于劣势。

无论是超强的图像处理能力还是为 AI 设置的神经网络加速器,都决定了这块芯片与 AP 2.0 定义的 8 颗不同视距、规格的摄像头感知、Tesla Vision 深度神经网络视觉处理工具强强绑定。这是一颗 AP 专用芯片,只有 AP 能释放它最大的性能。

下面我们说说它好在哪里。

首先自然是算力大增推动的全车 8 颗摄像头火力全开了。早在 2018 年 Q2 会议上,特斯拉 AI 总监 Andrew Karpathy 明确说过,AP 跑大型神经网络表现非常好,但是因为算力限制,目前还无法部署到车端。

特斯拉在发布会上提到,新芯片每块加速器都支持 8 颗摄像头以 2100 帧/s 的速度输入图像,每颗摄像头都是全景全分辨率输入。

其次,我们已经看到了双神经网络加速器,除此之外,特斯拉还设计了冗余电源、冗余计算,在 Model 3 上,特斯拉预埋了制动冗余和转向冗余。实现自动驾驶硬件冗余所需除了感知,其余的电源、定位、计算、控制、执行冗余,由此得以全部实现。

另外一个与自动驾驶强相关的功能是 CPU 容错(Lockstep)设计,主板运行时两套相同的硬件将同时处理相同的数据,强制执行不同芯片、内存间的时序相同,确保它们在同一时刻处理完全相同的数据,以此来保证汽车自动驾驶过程中的低时延特性。这对高速行车场景下的自动驾驶至关重要。

即便出现软件 Bug 错误或硬件故障,系统也能在不损失数据的前提下不间断运行。

Elon 对冗余容错设计的评价是:任何一部分都可能失效,但汽车将继续行驶,这块计算芯片运行失败的可能性远低于驾驶汽车过程中司机失去意识的可能性,至少低一个数量级。

最后是独立安全芯片设计,该芯片将以加密的方式主动检查所有指令和数据,以监控黑客攻击自动驾驶汽车的可能性。安全芯片将读取输入和输出数据,观察任何可疑的感知

信息,包括欺骗性的视觉信息(例如以假人欺骗汽车前方有行人)调整决策和控制。

整体来说,这块芯片完全实现了特斯拉,主要是 Elon 本人的设计需求。Elon 在发布会上给予了极高评价:

How could it be that Tesla, who has never designed a chip before, would design the best chip in the world? But that is objectively what has occurred. Not best by a small margin, best by a big margin.

从没做过芯片的特斯拉,怎么可能设计出世界上最好的芯片呢?但这是一个客观事实。不是比最好的芯片好一点儿,是好一大截。

Pete 和 Karparthy 也被 Elon 称为世界上最好的芯片架构师和世界上最好的计算机视觉科学家。

2018 年 8 月,AP 团队三位高管突然亮相特斯拉 Q2 财报会议,Elon 让 AP 团队做了财报会议的主角。这么做的原因在今天被揭开:2018 年 8 月,特斯拉测试了第一批 AP 3.0 车型,取得了很好的运行效果。在过去的几个月,特斯拉一直在对 AP 3.0 进行测试。

因此,1.0 到 2.0 的体验断崖式下跌的情况在 2.5 到 3.0 的过渡时不复存在。

AP 3.0 版本的 Model S/X 和 Model 3已经分别于 3 月 20 日和 4 月 12 日量产。另外,特斯拉下一代自动驾驶芯片,HW 4.0 主芯片的研发已于一年前启动。预计将在未来两年内实现量产,性能将比 3.0 芯片好 3 倍。

对行业

我们来重新审视一下 AP 2.0 传感器套件。

3 个前置摄像头(广角(60 米)、长焦(250 米)、中距(150 米))

2 个侧方前视摄像头(80 米)

2 个侧方后视摄像头(100 米)

1 个后视摄像头(50 米)

12 个超声波传感器(探测距离/精度翻倍)

1 个增强版前置雷达(160 米)

没有激光雷达,一颗都没有。

在今天的发布会上,Elon 接受投资人提问时再次表明了他对激光雷达的态度。

Lidar is a fool’s errand,Anyone relying on lidar is doomed. Doomed! [They are] expensive sensors that are unnecessary.

激光雷达是徒劳的,任何依赖激光雷达的公司都注定要失败的。注定!它们是昂贵的、不必要的传感器。

相对 CEO 纯粹的排斥,特斯拉 AI 高级总监 Andrej Karparthy 给出了一些更让人信服的解释。Karparthy 认为,世界是为视觉识别而构建的,激光雷达很难分辨塑料袋和轮胎的区别,而大规模神经网络训练和视觉识别对自动驾驶来说是必不可少的。

Andrej Karparthy

You were not shooting lasers out of your eyes to get here. In that sense, lidar is really a shortcut,It sidesteps the fundamental problems, the important problem of visual recognition, that is necessary for autonomy. It gives a false sense of progress, and is ultimately a crutch. It does give, like, really fast demos!

你并没有从眼中射出激光来看到这儿。从这个意义上说,激光雷达确实是一个捷径。它回避了基本问题,视觉识别的重要问题,这是实现自动驾驶所必需的。它给人一种进步的错觉,最终是一根拐杖。它确实提供了非常快的演示。

不同公司在技术路线上会有一些差异。早期的自动驾驶公司感知以激光雷达为中心,如今大多以多传感器融合为主,也有少数公司以计算机视觉为主。但这个世界上所有的自动驾驶创业公司 + 大公司,没有一家实现自动驾驶完全不用激光雷达,除了特斯拉。

一种合理的猜测是,激光雷达成本居高不下,特斯拉出于商业考量未选择激光雷达。实际上,上文中 Karparthy 的分析已经能代表 AP 团队的态度。还有另外一些证据表明,特斯拉不喜欢激光雷达完全是出于技术层面的差异。

首先,特斯拉不止一次被拍到使用激光雷达进行测试,Elon 今天也提到,他并不是讨厌激光雷达。Space X 团队自主研发了激光雷达,但对于汽车,激光雷达是昂贵且不必要的传感器。

其次,在这之前,Elon 已经解释过弃用激光雷达的原因。在成本之前,首先是感知融合的技术路线错误。

如果你坚持极为复杂的神经网络技术路线,做到了非常先进的图像识别技术,那么我认为你最大化地解决了问题。然后你需要把它和日趋复杂的雷达信息融合,如果你选择了波长在 400 nm - 700 nm 的范围内的主动质子发生器,其实是很愚蠢的,因为你被动地做到了这一点。

你最终会尝试在大约 4 毫米的雷达频率上主动发出质子,因为(该频率)可以穿透障碍物,你可以透过雪、雨、灰尘、雾……其他任何东西“看”清前方路况。令人费解的是,一些公司会用错误的波长来做主动质子发生系统。它们给汽车武装了一大堆昂贵设备,让汽车变得昂贵、丑陋也不必要。我觉得它们最终会发现自己在竞争中陷入劣势。

这是特斯拉和整个行业的分歧。下一个问题是,摄像头能扮演核心传感器的角色吗?

在这个问题上,特斯拉总算能和行业保持一致了。

在所有传感器中,摄像头拥有最丰富的线性密度,其数据量远超其他类型的传感器。一个行业共识是,基于视觉的感知在整个自动驾驶体系中的重要性正在持续提升。基于图像信息密度最高的优势,使得它处于整个感知融合的中心地位。

事实上,完全基于视觉来解决无人车的路况感知问题是可行的,但是还有很长的路要走,自动驾驶汽车的发展过程应该是一个视觉逐步替代高端激光雷达的过程。

所以,特斯拉与行业的真正分歧在于,行业普遍认可视觉潜力巨大,激光雷达也许有一天会退出历史舞台,但今天的计算机视觉和 AI 发展发展成熟度绝无可能独立完成感知。而 Elon 从第一性原理出发认为,激光雷达的加入会让技术路线误入歧途,所有人的终极目标都是摄像头实现感知。

特斯拉的底气来自跑在全球各地的 42.5 万辆 AP 2.+ 车型。MIT 按照特斯拉公布的交付量、特斯拉汽车平均行驶里程和 AP 启动状态下行驶里程计算,到 2019 年,特斯拉累计路测数据已经达到 4.8 亿英里,到 2020 年(估算)将突破 15 亿英里。按照 Elon 的说法,特斯拉路测数据占全行业总路测数据的 99%。

特斯拉此前被广泛质疑的一点是:在全车 8 颗摄像头全部开启参与感知后,每个月上传数据消耗流量平均仅为 1-3 GB,这个规模看起来很难说特斯拉在进行真正有效的数据采集。

在今天的发布会上,Karparthy 解释了这一问题。对于特斯拉来说,最大的优势也是最大挑战来自于对海量真实数据的处理,在早期进行短暂的人工标注(labeling)后,很快大量的障碍物识别都改为本地机器自动标注提升识别率。

只有出现摄像头完全无法理解或引起混乱的图像,才会上传到云端,由工程师进行标注,导入神经网络进行训练,直到神经网络掌握对该场景的识别。

其次,全球各地不同国家有着完全不同的路况、交规、暴雨、冰雹、大雾、甚至洪水、火灾、火山等罕见的长尾场景。每一次 AP 启用状态下的人为介入接管,系统都会记录下该场景的信息和数据,并自行学习人类的决策和驾驶行为。

Karparthy 特别提到,真实行车场景下的路况数据无法替代。对于竞品公司广泛采取的模拟器训练解决数据匮乏问题的做法,特斯拉用两句话回应:一个细节堪比真实世界的模拟器本身会比自动驾驶系统的设计难度更大;使用模拟器改进,就像自己改自己的作业,提升有限。

对于这个行业来说,特斯拉手握全球最大规模的自动驾驶车队,开始计算机视觉 + AI(软硬件) + 海量真实数据的探索。时至今日,通用 Cruise COO Daniel Kan 对 AP 团队的评价仍然最为精准:They are push the boundary of technology.

对用户

在发布会后半段,特斯拉对一些问题做出了解释。比如,AP 运行状态下的最小跟车距离大概在 3 米左右,在中国堵车场景下这样的距离给侧方车辆强行并道提供了足够的空间。

特斯拉提到了影子模式机制,即每一次此类场景下驾驶员接管加速靠近前车,系统都会记录下驾驶员的驾驶行为,上传到云端。当同一行为比例足够高的时候,神经网络的决策机制就会发生变化,并被推送给成千上万的用户。

Stuart Bowers

所以,在不远的将来,AP 一定会越来越好用,不断接近自动驾驶。但作为用户的你都要在任何时候都要明白,在官方承诺全自动驾驶技术实现之前,无论系统多么好用,它都不是自动驾驶。

Elon 在发布会上提到,AP 在第一阶段的自动驾驶,仍然强制要求乘客坐在驾驶位上

关注前方路况。听起来是不是非常矛盾?

在此前接受 Ark Capital 采访时,Elon 做了更详细的说明。

到今年年底,特斯拉将会功能性实现(Feature Complete)自动驾驶。功能性实现的意思是,车辆能从停车场驶出找到你,接上你并把你送到目的地,这个过程中你需要注意路况并有极小的概率需要在适当的时候接管车辆,但在大多数时候根本无需驾驶员介入。

人们认为这是 100% 零失误的全自动驾驶,不需要任何人类监管,实际上并不是这样的。功能性实现自动驾驶的特斯拉可以应对 99.9999% 的场景,但在那之后需要增加更多的 9。

特斯拉也明确说明,在某些极端场景,如暴雨、冰雹、大雾之类的恶劣

天气下,自动驾驶系统存在停止运行的风险。事实上在系统停止运行,驾驶员接管后,系统会进行学习或以镜子模式收集信息和数据。

所以,我们完全无意讨论 Elon 在最后放飞环节提到 2020 年的 100 万辆 Robo-Taxi 自动驾驶车队打车服务。真正值得关注的问题是,在车队、芯片、算法先后到位后,特斯拉 Autopilot 从去年的完全不可用,到如今具备主流竞争力的 L2,正在快速向 L4 逼近。

特斯拉可能是全球第一家需要跟国家级监管机构谈判大规模投放自动驾驶车队的公司。这背后需要全体 AP 2.+ 车主正确理解系统的边界,按照用户说明书使用系统。不要让技术的进步以悲剧为代价。

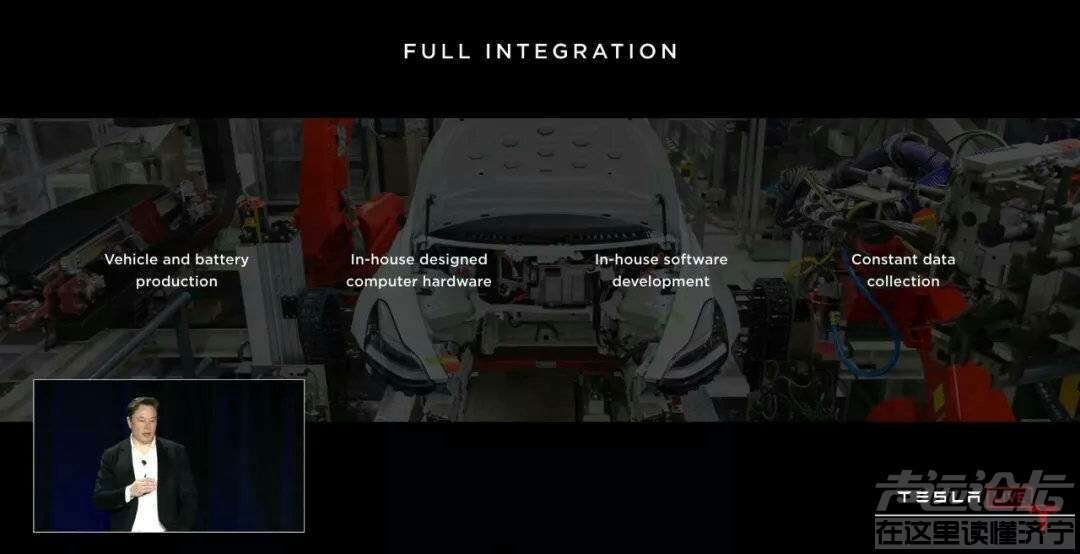

2016 年初启动,2019 年中量产。AP 芯片发布后,特斯拉本质上已经拼上了最后一块关键的版图。一图总结特斯拉未来十年核心竞争力。